❖本調査資料に関するお問い合わせはこちら❖

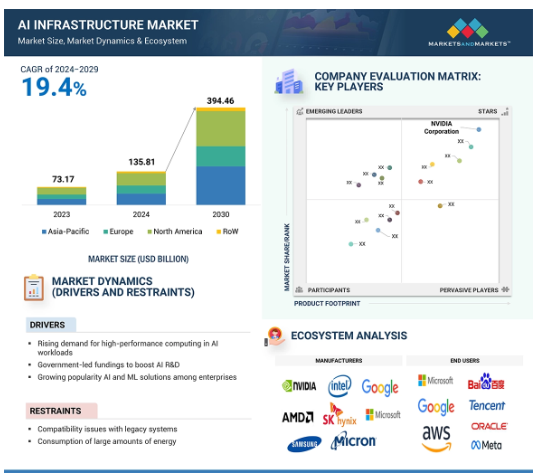

AIインフラの世界市場は、2024年の1,358億1,000万米ドルから2030年には3,944億6,000万米ドルへと、2024年から2030年の推定期間中に年平均成長率19.4%で成長する見込みです。

AIインフラ市場は、複雑なAIワークロードを管理し、より高速で効率的なデータ処理を可能にするハイパフォーマンス・コンピューティング(HPC)に対する需要の高まりによって、力強い成長を遂げています。ジェネレーティブAI(GenAI)アプリケーションや大規模言語モデル(LLM)の急増は、AIワークロードの学習と推論に膨大な計算能力を必要とするため、高度なAIインフラの必要性をさらに高めています。クラウドサービスプロバイダー(CSP)は、スケーラブルでコスト効率の高いソリューションを提供するためにAIインフラを採用する傾向が強まっており、市場の拡大に拍車をかけています。NVIDIAの最先端のBlackwell GPUアーキテクチャなどの技術の進歩は、比類のないパフォーマンスとスケーラビリティを提供することで、AIインフラストラクチャの採用を加速しています。

AIインフラ市場における魅力的な機会

北米

2023年のAIインフラ市場において、北米が37.0%の最大シェアを占めています。

クラウドサービスプロバイダやBFSI、ヘルスケア、小売、eコマースなどの企業は、AIインフラ市場のプレーヤーに有利な機会を創出する可能性が高い。

北米のAIインフラ開発に対する米国政府による好意的なイニシアチブと補助金が市場成長を促進。

今後5年間は、製品発表が市場プレーヤーに有利な成長機会を提供する見込み。

NVIDIA Corporation(米国)、Advanced Micro Devices, Inc.(米国)、Intel Corporation(米国)、SK HYNIX INC.(韓国)、SAMSUNG(韓国)がAIインフラ市場の主要プレーヤー。

世界のAIインフラ市場のダイナミクス

DRIVER: – AIワークロードにおけるハイパフォーマンスコンピューティングの需要の高まり

AIワークロード、特に機械学習とディープラーニングは、従来のコンピューティングシステムでは対応できない前例のないレベルのデータ処理を必要とします。ハイパフォーマンス・コンピューティング(HPC)システムは、大規模なデータセット管理と複雑なアルゴリズムを驚異的な速度で実行するためのソリューションとして登場し、高度化するAIモデルの計算要件に適切に対応しています。このようなモデルは、学習と推論に膨大なリソースを必要としますが、HPCを利用することで、開発と展開にかかる時間が短縮され、迅速な意思決定と業務効率の向上が可能になります。ヘルスケア、金融、自動車などの業界では現在、人工知能を中核業務に急速に組み込んでおり、スケーラビリティと結果の精度を高めるために、HPCインフラストラクチャへの依存度が高まっています。これに伴い、データの急激な増加により、大きなデータセットを解析し、実用的な洞察を提供するための強力なシステムに対する需要が高まっています。HPCは、AIがこのような需要に対応できるようにします。このような需要の高まりを受けて、HPCクラスタ、最先端のGPU、その他の専用ハードウェアを含む高度なインフラストラクチャへの投資が増加しています。このような投資の増加は、AIインフラストラクチャ市場の高成長を支えています。AIインフラストラクチャ市場は、AIに関連する非常に集約的な計算タスクをサポートする必要性に後押しされ、業界全体でAI主導のイノベーションの次の波を可能にします。

制約事項 レガシーシステムとの互換性の問題

AIインフラ市場の成長における大きな阻害要因の1つは、レガシーシステムとの互換性の問題です。製造、金融、政府などの伝統的なセクターの企業は、AIや機械学習のワークロードに関連する高い計算需要をサポートするために開発されたわけではないレガシーITシステムに依存しています。これらのレガシーシステムには、AIインフラストラクチャに必要な処理能力、ストレージ機能、柔軟性がありません。そのため、このような組織は、高度に先進的なAIソリューションを組織に統合することができません。その結果、企業はAI技術を吸収するためにレガシーシステムをアップグレードまたはリプレースしようとする際に、技術的および運用上の問題を経験しています。主な課題は、レガシーインフラストラクチャをAIに最適化されたプラットフォームに移行するために必要な高いコストと複雑性です。さらに、多くのレガシーシステムは組織の中核業務に深く統合されているため、新しいAIインフラストラクチャで既存のワークフローを混乱させることは危険です。この移行において事業継続性を維持する必要があるため、AI技術の採用スピードが遅くなり、AIの可能性を最大限に活用しようとする企業にとって障壁となります。

AI-as-a-Service プラットフォームの台頭

AI-as-a-Service(AIaaS)プラットフォームの台頭は、特に、ハードウェアや専門知識に多額の先行投資をすることなく人工知能の力を活用したいと考えている中小企業にとって、AIインフラ市場の成長にとって重要な機会をもたらします。AIaaSは、より高度なAIを導入するための積極的な一歩を踏み出そうとしている企業にとって、AIツールやインフラへのサブスクリプションまたは従量課金ベースのアクセスを可能にします。Amazon Web Services社(米国)、Microsoft Azure社(米国)、Google Cloud社(米国)などの主要なクラウドプロバイダーは、中小企業がGPUやTPU、特別に設計されたプロセッサなどの高価なAIハードウェアに投資する必要がないAIaaSプラットフォームを提供しています。その代わりに、企業はスケーラブルなクラウドベースのソリューションを通じて強力なAIインフラにアクセスできるため、参入障壁が大幅に下がります。このシフトは、意思決定の質の向上、顧客体験の改善、業務の最適化のためにAIがより多く使用されている小売、医療、金融サービス業界にとって特に有益です。競争力の向上により中小企業でAIaaSの利用が増加しているため、AIインフラストラクチャのさらなる成長が見込まれます。

課題:分散AIシステムにおけるデータ・セキュリティと整合性の維持

AIインフラ市場で最も重要な課題の1つは、データのセキュリティと整合性の維持です。複数のデータセンター、エッジデバイス、またはクラウド環境内の分散AIシステムは、異なる場所にまたがる大量のデータの固有の伝送、保存、処理を伴います。このように広範囲に分散することで、サイバーセキュリティ侵害、ハッキング攻撃、不正アクセスのリスクが高まります。なぜなら、機密情報は、それぞれ異なるセキュリティ・レベルの多数のネットワーク上を移動する必要があるからです。分散AIシステムでは、データをリアルタイムで共有して処理する必要があります。そのため、データの完全性という観点から、データの伝送を保護する必要があります。データがネットワーク内の他のインフラに送信されるまでに改ざんや破損がないことを保証することは、より重要な課題の1つです。データの完全性に問題があると、AIモデルの予測に影響が出たり、誤った意思決定が行われたり、ビジネス成果が損なわれたりする可能性があります。分散システムには、ロットセンサー、スマートフォン、自律走行車などのエッジデバイスでローカルにデータを処理するエッジコンピューティングが含まれることがよくあります。このようなデバイスは、物理的なアクセスやサイバー脅威に対して最も脆弱であり、AIインフラストラクチャ全体のセキュリティと信頼性を損なう可能性があります。

世界のAIインフラ市場のエコシステム分析

AIインフラのエコシステムは、設計者、WFE/SEMICAP企業、メーカー、エンドユーザーで構成されます。これらのそれぞれが、この分野における最終的なイノベーションを達成するために、知識、リソース、専門知識を共有することで、AIインフラストラクチャを進化させるという目的に向かって協力しています。エヌビディア・コーポレーション(米国)、アドバンスト・マイクロ・デバイセズ(米国)、インテル・コーポレーション(米国)などのメーカーは、AIインフラストラクチャ市場の中核であり、さまざまなアプリケーション向けのAIインフラストラクチャ製品の開発を担っています。

予測期間中、GPUセグメントが高シェアを維持

GPUセグメントは、機械学習、深層学習、データ分析などのAIアプリケーションに不可欠な高度な並列タスクを処理する比類のない能力により、AIインフラストラクチャ市場で最も高い市場シェアを占めています。Amazon Web Services(米国)、Microsoft Azure(米国)、Google(米国)、IBM(米国)、Oracle(米国)などのハイパースケールクラウドプロバイダーは、企業や研究者向けにスケーラブルなAI機能を拡張するためにGPUに依存しています。この汎用性により、GPUは大規模モデルのトレーニングからリアルタイムの推論まで、幅広いAIタスクをサポートし、多様なワークロードに対応するデータセンター・インフラを最適化します。NVIDIA Corporation (米国)、Advanced Micro Devices, Inc (米国)、Intel Corporation (米国) などの大手企業は、エスカレートするAI需要に対応するため、GPUイノベーションを推進しています。NVIDIAが最近2024年3月に発表したBlackwellプラットフォームは、コストとエネルギー消費を最大25倍削減し、AIインフラにおける持続可能性の懸念に対応するという大きな飛躍を示しました。Blackwellの革新的なテクノロジーは、AIにとどまらず、エンジニアリング・シミュレーションやコンピュータ支援薬剤設計などの分野にも広がっています。ヘルスケア、金融、自動車などの分野で複雑な課題に対するAIへの依存が高まる中、GPUの卓越した性能、エネルギー効率、スケーラビリティは、AIインフラストラクチャ市場における支配的な役割を確固たるものにしています。

予測期間中、推論分野が最大の市場シェアを占める見込み

推論機能は、専用ハードウェアにおけるリアルタイムAIアプリケーションの需要が飛躍的に高まっていることから、AIインフラストラクチャ市場を支配することになるでしょう。AIモデルは、ヘルスケア、金融、自律走行車、顧客サービスなどの業界全体で、生産現場への導入が進んでいるため、大規模な推論をサポートする効果的かつ効率的なコンピューティング・インフラへの要求が高まっています。この傾向は、自然言語処理や画像生成などの生成型AIモデルによってさらに加速しており、推論リソースに対する高い需要が生じています。AIベースのチャットボット、予測分析、推薦システムの広範な採用は、スケーラブルな推論ソリューションの重要性を強調しています。例えば、2024年6月、シスコ(米国)とエヌビディア・コーポレーション(米国)は提携し、ソフトウェアとインフラストラクチャの管理、構築、最適化を行い、ジェネレーティブなAIワークロードを拡張するデータセンター向けソリューション「Cisco Nexus HyperFabric AIクラスター」を発表しました。そのクラウド管理機能により、顧客はデータセンター、コロケーション施設、エッジサイトにまたがる大規模なファブリックを容易に導入、管理することができます。ビジネスでジェネレーティブAI技術の採用が進むにつれ、効率的な推論インフラへのニーズも比例して高まり、AIインフラ市場における同社のリーダーシップは確固たるものになるでしょう。

予測期間中、クラウドサービスプロバイダー(CSP)が最大の市場シェアを占める見込み

スケーラブルでコスト効率に優れたAIコンピューティング・ソリューションの需要が高まっていることから、クラウドサービスプロバイダー(CSP)セグメントがAIインフラストラクチャ市場を支配することになるでしょう。企業は、社内にインフラを構築し、それを拡張するための高コストを回避するために、CSPへの依存度を高めています。その結果、先進的なハードウェア、ネットワーキング機器、ストレージに多額の投資が行われています。例えば、マイクロソフトは2024年5月、タイでクラウドとAIインフラを開発する計画を発表し、高度なAIワークロードをサポートするデータセンター機能を拡張しました。CSPは、あらかじめ構築されたモデル、開発ツール、およびインフラストラクチャー・アズ・ア・サービス・ソリューションを提供することで、AIの導入をさらに民主化し、金融、ヘルスケア、小売などの業界が導入を加速できるようにしています。規制要件とデータ主権への懸念が地域データセンターの設立に拍車をかけ、遅延の削減とローカルデータ処理の改善によってパフォーマンスが向上しています。AirtelとGoogle Cloudが2024年5月に提携したジェネレーティブAIソリューションの展開などのコラボレーションは、地理空間や音声分析などのアプリケーション向けに高度なAIを搭載したツールを提供することにCSPが注力していることを浮き彫りにしています。これらのツールは堅牢な計算リソースを必要とするため、CSPは高速相互接続とインテリジェント・ネットワーキングへの投資を進めています。これらの多様なニーズに対応することで、CSPはシームレスで高性能なAIインフラストラクチャ・ソリューションを全世界に提供するリーダーシップを確固たるものにしています。

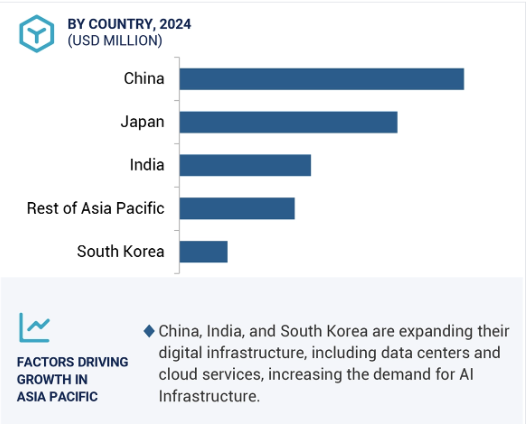

アジア太平洋地域が予測期間中にAIインフラストラクチャ市場で高いCAGRを維持

アジア太平洋地域のAIインフラストラクチャ市場は、AIの研究、開発、導入の著しい進歩により、最も高いCAGRで成長する見込みです。中国、日本、韓国、シンガポールによるAI技術への高額の投資が、学界、産業界、政府間の連携を促進しています。この地域の政府は、AIワークロード用に最適化されたデータセンターなど、AIインフラ開発に多額の資金を投入しています。中国の「次世代人工知能開発計画」は、2030年までに同国をAIの世界的リーダーとして位置づけることを目指しています。これは、強力なAIインフラ展開の強固なエコシステムを構築することで達成されます。同様に、韓国のAI国家戦略や日本のSociety 5.0イニシアティブは、イノベーションを支援するAIインフラ能力を強化しています。アジア太平洋地域の企業は競争力強化のためにAIを急速に導入しており、ハイパフォーマンス・コンピューティング・システム、高度なGPU、スケーラブルなクラウドベースのインフラに対する需要の高まりにつながっています。同地域はデジタルトランスフォーメーションと規制支援に強く注力しており、AIの導入がさらに加速しています。AI技術が医療、金融、製造などの分野に不可欠になるにつれ、アジア太平洋地域は、その投資と進歩を活用して大幅な成長を促進し、世界のAIインフラストラクチャ市場をリードする態勢を整えています。

AIインフラ市場の最新動向

2024年6月、SK HYNIX INC.(韓国)は、オンデバイスAI向けに最適化されたPC用SSD PCB01を発売。PCB01は、AIの学習と推論に必要な大規模言語モデル4(LLM)の運用を可能にする、1秒あたり14GBと12GBのシーケンシャル読み出し/書き込み速度を提供します。

2024年6月、アドバンスト・マイクロ・デバイセズ社(米国)はマイクロソフト社と提携し、Ryzen AIを搭載したCoPilot+ PCを提供します。この提携は、AIの急速な加速をサポートし、高性能コンピューティング・プラットフォームの需要増加を促進します。

2024年4月、Micron Technology, Inc.(米国)とSilvaco Group, Inc.(米国)は提携を拡大し、Fab Technology Co-Optimization(FTCO)と名付けられたAIベースのソリューションを開発しました。これにより、顧客は製造データを使用して機械学習ソフトウェアシミュレーションを実行し、ウエハ製造プロセスをシミュレートするコンピュータモデルを作成することができます。

2024年3月、NVIDIA Corporation(米国)は、コンピューティングとAIワークロード向けのNVIDIA Quantum-X800 InfiniBandおよびNVIDIA Spectrum-X800 Ethernetネットワーキングプラットフォームを発表。これらは800Gbpsのスループットが可能で、大規模AI向けに設計されています。さまざまなデータセンター向けに設計されたこれらのプラットフォームは、AIおよびデータ処理アプリケーションを高速化するソフトウェアを備え、NVIDIAの新しいBlackwellアーキテクチャと統合されています。

2024年2月、SAMSUNG(韓国)は、AIサービスプロバイダーの大容量要件に対応するため、36GBのHBM3E 12H DRAMを開発しました。AIトレーニング速度を34%向上させ、データセンターの総所有コストを削減することができます。

主要市場プレイヤー

AIインフラ市場上位企業リスト

NVIDIA Corporation (US)

Advanced Micro Devices, Inc. (US)

SK HYNIX INC. (South Korea)

SAMSUNG (South Korea)

Micron Technology, Inc. (US)

Intel Corporation (US)

Google (US)

Amazon Web Services, Inc. (US)

Tesla (US)

Microsoft (US)

Meta (US)

Graphcore (UK)

Cerebras (US)

Groq, Inc. (US)

Shanghai BiRen Technology Co., Ltd. (China)

1 はじめに

2 研究方法論

3 要旨

4 プレミアムインサイト

5 市場概要

5.1 はじめに

5.2 市場ダイナミクス

5.3 顧客のビジネスに影響を与えるトレンド/混乱

5.4 価格分析

主要企業の平均販売価格動向(計算機別

平均販売価格動向(地域別

5.5 バリューチェーン分析

5.6 エコシステム分析

5.7 投資と資金調達のシナリオ

5.8 技術分析

主要技術

– ジェネレーティブAI

– 会話型AI

– AI最適化クラウドプラットフォーム

補完技術

– ブロックチェーン

– エッジコンピューティング

– サイバーセキュリティ

隣接テクノロジー

– ビッグデータ

– 予測分析

5.9 クラウドサービスプロバイダー(CSP)によるデータセンターの今後の展開

クラウドサービスプロバイダーの設備投資

プロセッサ・ベンチマーク

– GPUベンチマーク

– CPUベンチマーク

特許分析

貿易分析

– 輸入シナリオ

– 輸出シナリオ

主要会議とイベント(2024-2025年)

ケーススタディ分析

規制情勢

– 規制機関、政府機関、その他の組織

– 規制基準

ポーターズファイブフォース分析

– 新規参入による脅威

– 代替品の脅威

– 供給者の交渉力

– 買い手の交渉力

– 競争ライバルの激しさ

主要ステークホルダーと購買基準

– 購買プロセスにおける主要ステークホルダー

– 購買基準

AIサーバー業界の展望

80

6.1 導入

6.2 AIサーバーの現在の普及率と成長予測

6.3 AIサーバー市場、プロセッサー種類別

GPUベースサーバー

FPGAベース・サーバー

asicベースサーバー

6.4 AIサーバー市場:機能別

トレーニング

情報

6.5 AIサーバー市場シェア分析、2023年

Aiインフラ市場、オファリング別

100

7.1 導入

7.2 COMPUTE

GPU

CPU

FPGA

TPU

DOJO & FSD

トレニウム&インフェクティア

アテナ

T-HEAD

MTIA

– LPU

– その他のASIC

7.3 メモリ

DDR

HBM

7.4 ネットワーク

NIC/ネットワーク・アダプタ

– インフィニバンド

– イーサネット

インターコネクト

7.5 ストレージ

7.6 サーバーソフトウェア

AIインフラ市場、機能別

120

8.1 導入

8.2 トレーニング

8.3 情報

AIインフラ市場、展開別

150

9.1 導入

9.2 オンプレミス

9.3 クラウド

9.4 ハイブリッド

導入

ジェネレーティブAI

– ルールベース・モデル

– 統計モデル

– ディープラーニング

– 生成的逆数ネットワーク(GAN)

– オートエンコーダ

– 畳み込みニューラルネットワーク(CNN)

– 変換モデル

機械学習

自然言語処理

コンピュータビジョン

AIインフラ市場、エンドユーザー別

190

はじめに

クラウドサービスプロバイダー(CSP)

エンタープライズ

– ヘルスケア

– BFSI

– 自動車

– 小売・Eコマース

– メディア&エンターテインメント

– その他

政府機関

AIインフラ市場、地域別

240

はじめに

北米

– マクロ経済見通し

– 米国

– カナダ

– メキシコ

欧州

– マクロ経済見通し

– 英国

– ドイツ

– フランス

– イタリア

– スペイン

– その他のヨーロッパ

アジア・パシフィック

– マクロ経済の見通し

– 中国

– 日本

– 韓国

– インド

– その他のアジア太平洋地域

ROW(ロウ

– マクロ経済見通し

– 中東

– アフリカ

– 南米

AIインフラ市場、競争環境

260

はじめに

主要プレーヤーの戦略/勝利への権利

収益分析

市場シェア分析

企業評価と財務指標

製品/ブランド比較

企業評価マトリックス:主要プレーヤー、2023年

– スター

– 新興リーダー

– 広範なプレーヤー

– 参加企業

– 企業フットプリント: 主要プレーヤー(2023年

企業評価マトリックス:新興企業/SM、2023年

– 先進的企業

– レスポンシブ企業

– ダイナミックな企業

– スターティングブロック

– 競争力のベンチマーク 新興企業/中小企業、2023年

競争シナリオとトレンド

– 製品上市

– ディール

AIインフラ市場、企業プロファイル

290

主要プレーヤー